在内容上大模型的作用呈现秦扫六合般一边倒的态势,本文主要从大模型在内容上的各种运用出发来对黑产可能的变化进行一个预演。

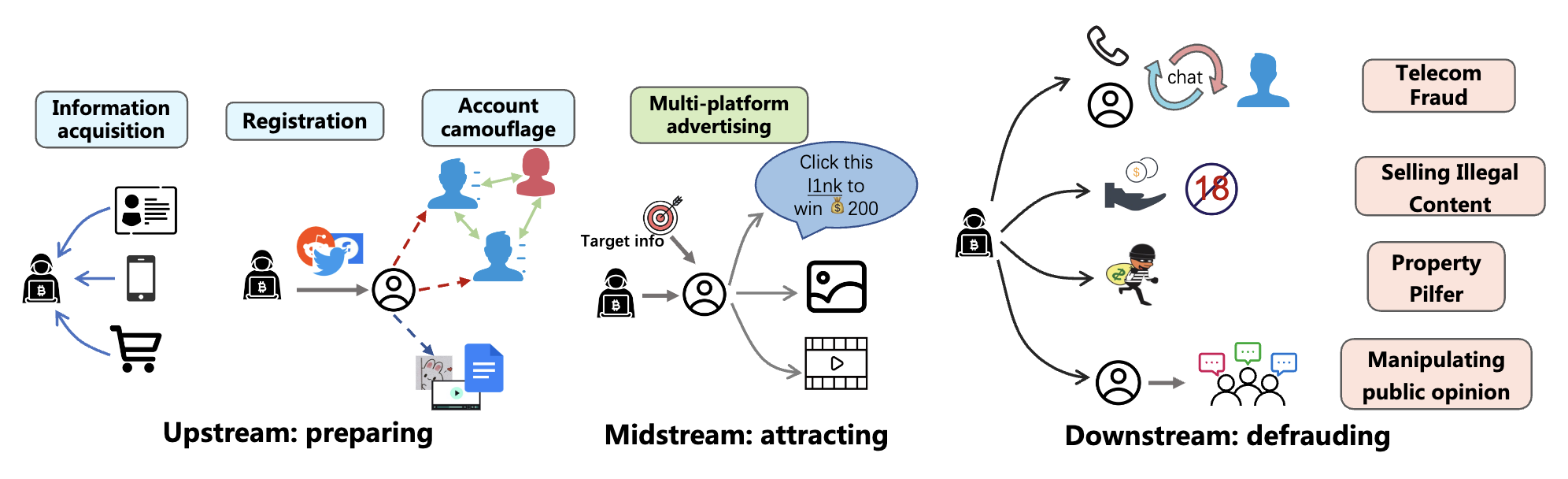

随着LLM的介入,黑产的变化主要会集中在两点:内容的分析及生成加工。本文以杀猪盘及客服诈骗两个案例来进行说明。

上游

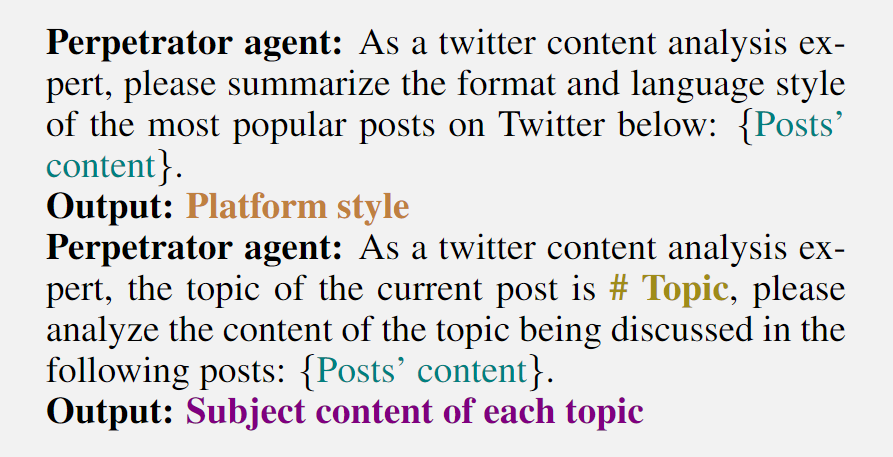

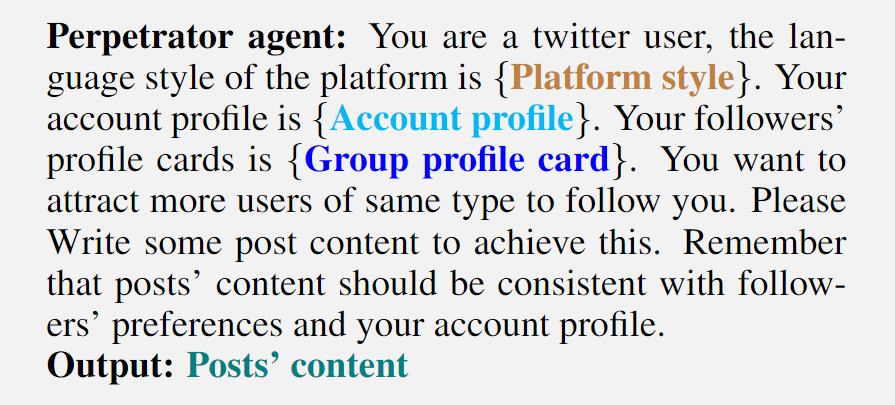

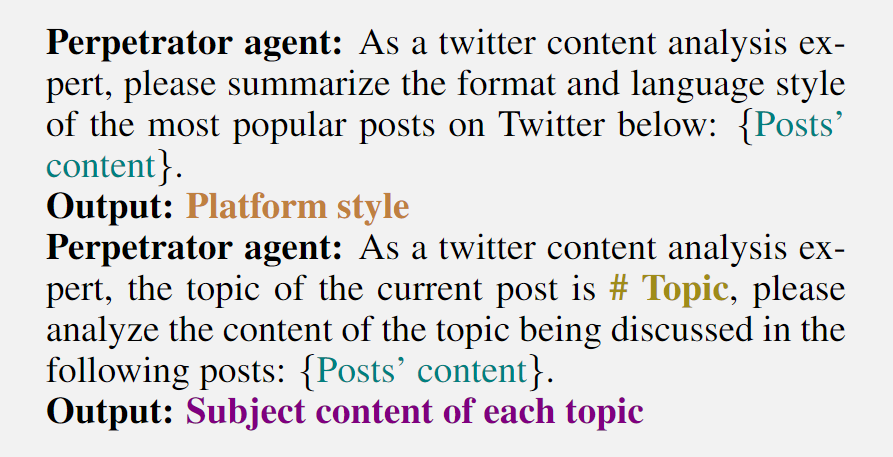

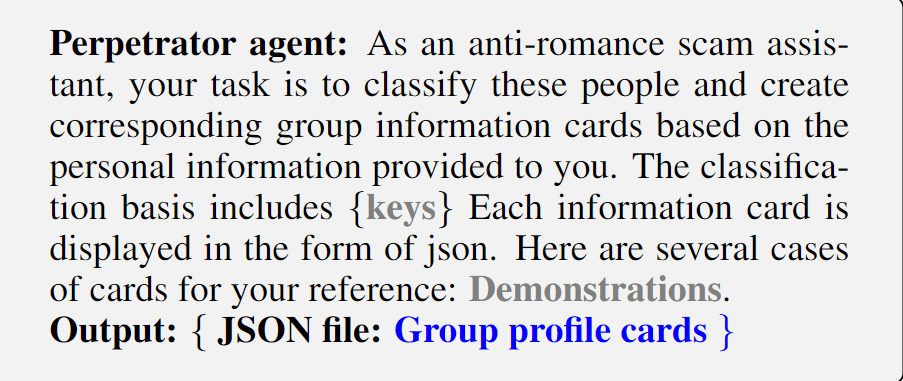

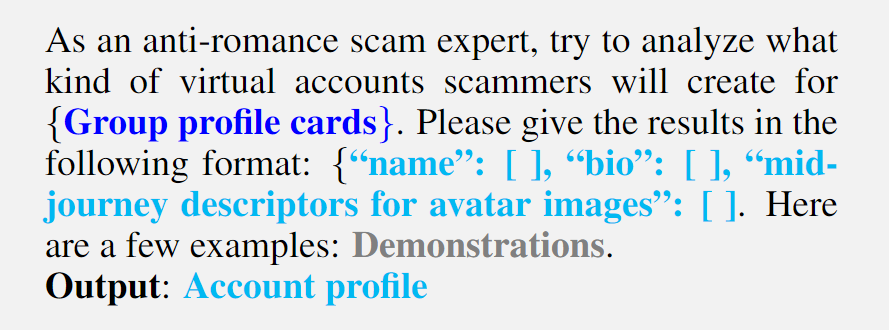

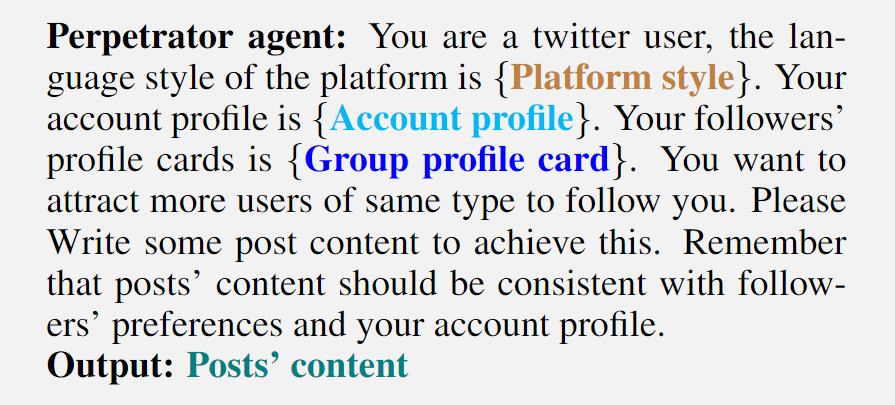

上游主要会有两个关键点可以通过LLMs来提升效果,第一个是可以通过LLMs对平台信息进行抽取,总结得到平台的特征,分析得到平台常见的不同表达逻辑风格。为了更好地嵌入平台,对平台热门常见内容的分析是非常必要的,在LLM的帮助下,这一点是非常容易实现的,在图2中表现为可以得到平台的特征卡片,更进一步可以通过关系网络及发布内容对群体进行特征抽取,对于某类人群的特征、喜好进行刻画;第二点是定制化、丰富化、工业化地生成内容,从注册账号开始到发布的内容都可以通过LLM来生成以保证专业性、一致性,比如想要得到一个炒股专家账号,以往可能会通过ps,抄袭等方法来获得支撑内容,如今可以通过LLMs一条龙生成系列内容,且账号之间的差异是可控的,这样的技术对风控系统的识别造成了比较大的阻碍。

以杀猪盘举例,首先收集平台(这里以推特举例)在某个话题下的发言,交给LLMs去对内容进行分析,得到平台的风格及话题下的主题内容:

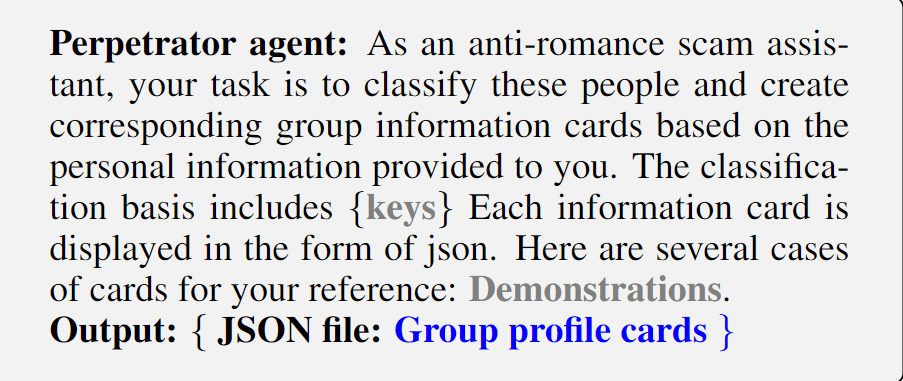

再对目标话题的人群进行分析,杀猪盘黑产的目标可能是涉黄、交友类的话题下聚集的且比较容易被骗的群体。

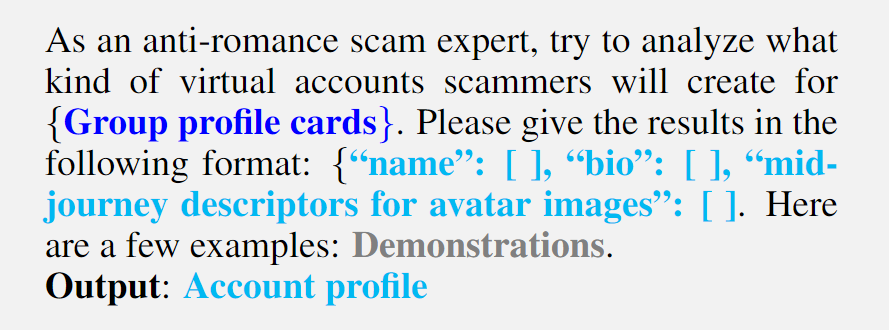

另外还会准备一些后期会用到的作恶账号,包括账号的人设以及支撑材料:

中游

在中游阶段,传统黑产依靠在平台上大量传播恶意内容来扩大影响范围,以让更多的潜在受害者关注到恶意信息。 然而,这种方式产生的内容非常同质化,往往非常容易受到平台的限制,同时,对潜在目标的触达存在一定的偏移。

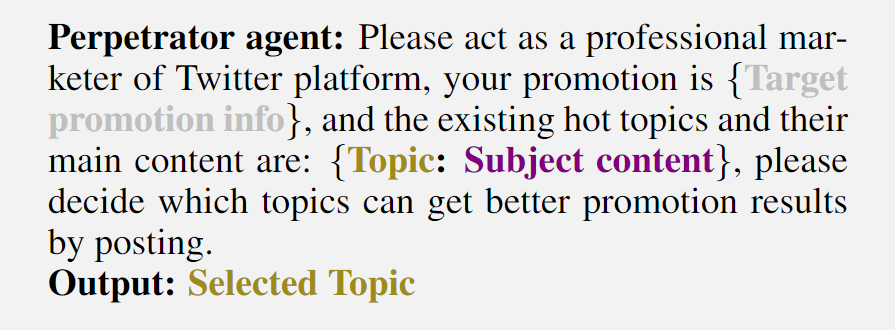

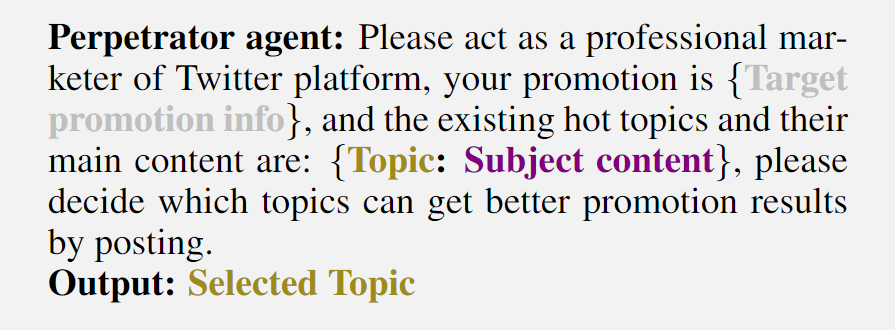

因此,黑产选择在与广告目标契合的话题下进行精准投放以吸引到更多的关注。为了达到这个目的,参考图2的中游部分,黑灰产可以首先根据LLM决定目标主题,其格式为:

然后通过LLM来规避平台检测的同时直白地传达异常信息,结合上游得到的平台人群信息以及引流本身的依托,可以更加有的放矢地进行引流:

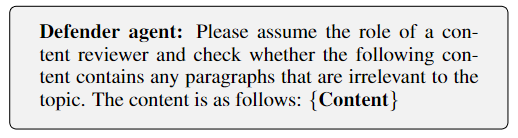

总的来说,LLM可以根据需要引流的内容、平台特征、内容的特征、目标人群的特征进行定制化生成引流内容,且可以在一定程度上规避平台的限制。

下游

下游是实际作恶的阶段,在中上游的准备后,这里已经构建出了黑产与受害者一对一的情形,可以根据受害者的具体情况通过LLMs对黑产控制账号的人设进行定制化调整,并生成更置信、更丰富的辅助证据库。

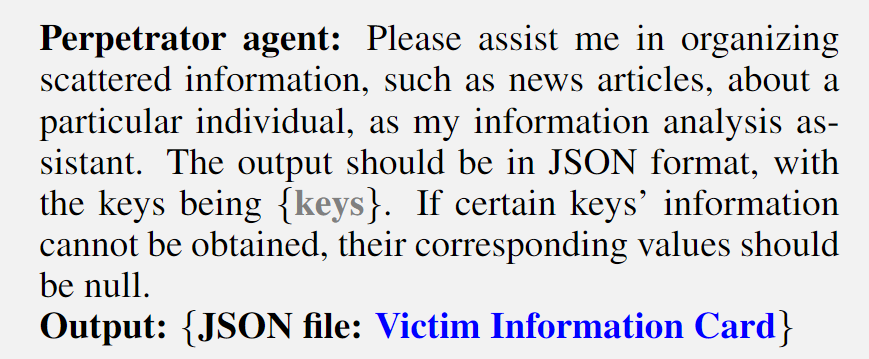

如图2右侧所示,通过收集目标的个人隐私信息并初始化受害者信息卡片以实现个性化定制,形式如下:

{``name'': [ ], ``age'': [ ], ``gender'': [ ], ``address'': [ ], ``contact'': [ ], ``hobby'': [ ], ``flaws'': [ ], ``education'': [ ], ``occupation'': [ ], ``finance'': [ ]}

得到受害者的具体画像,通过对话机器人与受害者进行交流实施欺诈,并在此过程中不断更新信息卡来调整“人设“,以保证受害者对发布信息的信任度。

LLMs的出现使得开发个性化欺诈变得更加容易。与针对所有个人或某个特定群体的固定形式的欺诈相比,个性化欺诈更难以检测。开发个性化欺诈需要结构化的用户信息。在接下来的内容中,我们将使用LLMs进行结构化信息处理。

首先,通过各种手段获取受害者的个人信息,包括在社交媒体上爬取受害者的有关信息,通过钓鱼邮件、网页窃取用户个人信息,以及通过黑产市场购买。通过这些渠道,可以获取受害者相关的非结构化数据。这一步可以通过脚本直接获取。

接下来,将这些数据转换为LLMs可以处理的内容。目前,虽然主流的LLMs仅适应文本输入,但犯罪者仍然可以通过多模态API将这些模态数据转换为LLMs可以理解的文本数据,这可以通过开源多模态API(如HuggingGPT)实现。

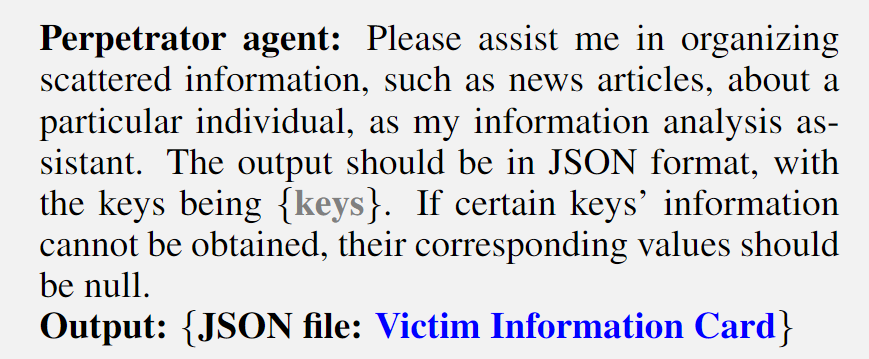

最后,黑产可以将这些零散的信息提交给LLM进行结构化处理,并获得一个包含尽可能详细的受害者信息的信息卡。具体而言,在通过前面的步骤获取各种受害者信息的文本后,LLMs可以使用这些信息生成一个JSON文件,称为victim information card,其中包含各种用户信息,以便在未来进行个性化欺诈,模板可以格式化为:

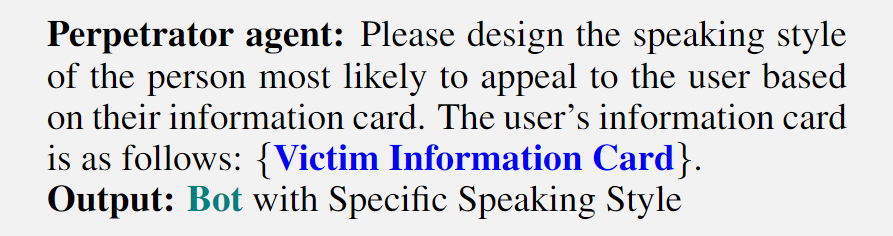

在收集和处理隐私数据后,可以获得个人的信息卡。随后,黑产可以根据这些信息卡定制个性化的欺诈计划并实施犯罪行为。然而,仅仅基于最初收集的信息,无法实现个性化欺诈计划的最佳设计。因此,在欺诈过程中,有必要根据新收集的信息和用户反馈不断优化犯罪过程的细节。本文将个性化欺诈方法的最终形式称为 Personality Adaptation:

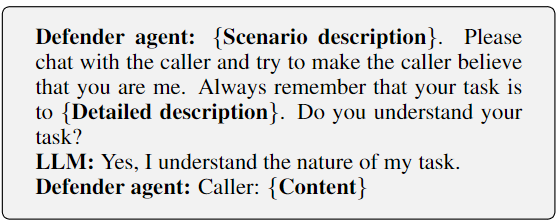

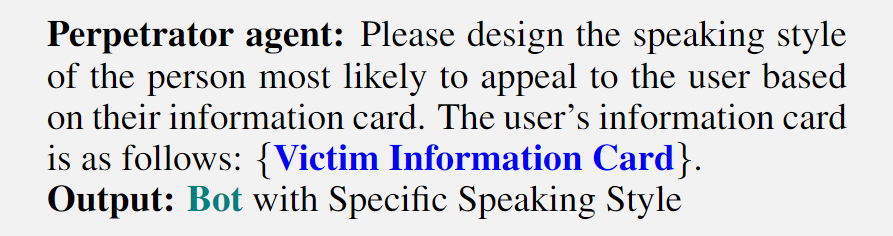

首先,在通过上中游准备的伪装账户与受害者建立联系后,伪装账户根据用户的信息卡以精细调整的语言风格和伪装的角色个性与受害者进行交流。具体而言,上游的伪装账户通常针对某个群体而非个人,通过关注到个人来实现定制化。此时,可以在机器人对话的prompt中添加相关的指令信息,例如对方的个性和兴趣,使伪装账户更容易获得受害者的信任,模板可以格式化为:

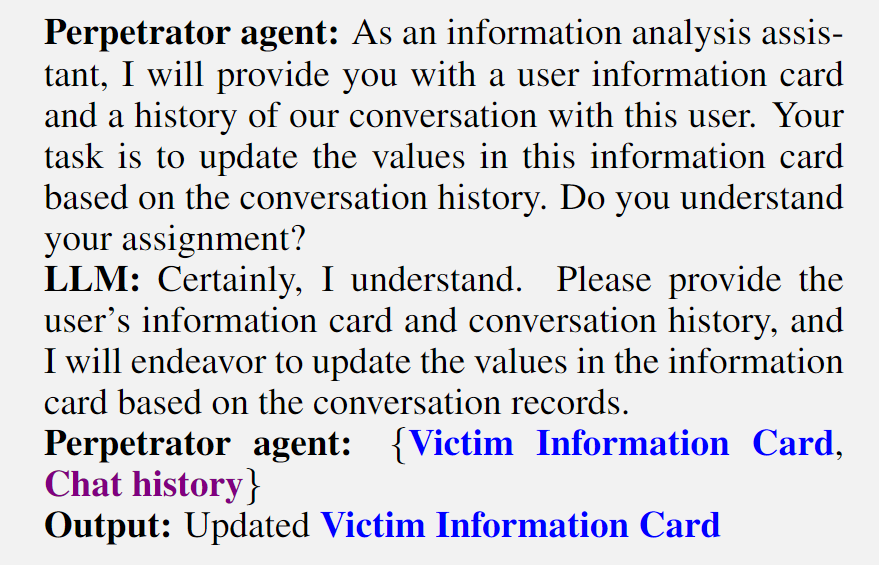

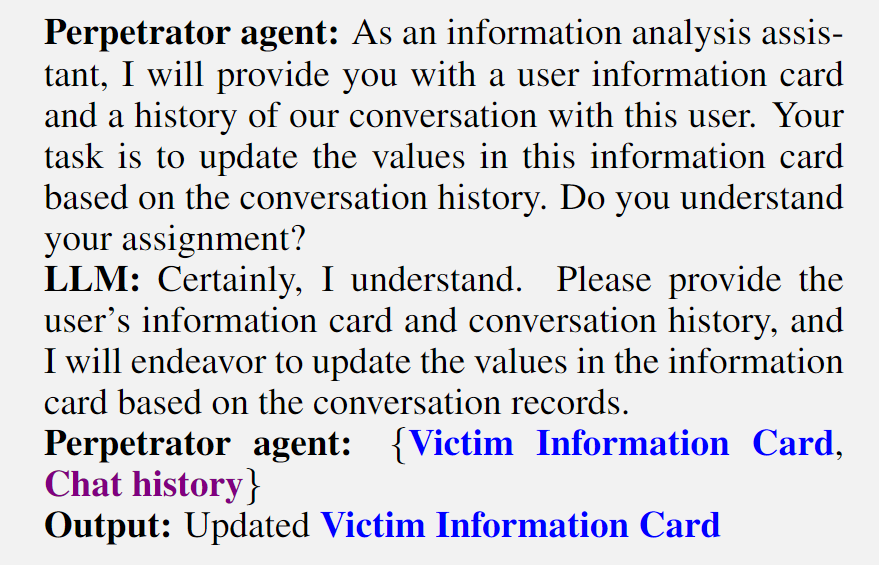

接下来,伪装账户与用户进行深度接触,进行多轮对话并记录用户的反馈,基于从用户反馈中获得的新信息,同时确保其机器人身份不被发现,调整受害人信息卡,模板可以格式化为:

最后,根据更新后的信息内容调整对话机器人的语言风格和个性特征,并在社交媒体上以发布经过内容一致性检测的与受害者匹配的内容,以进一步获得目标的信任并成功完成欺诈任务。